フィクションに登場するAIは、その時代の技術的水準や社会の価値観を反映しながら、知性への期待や不安を象徴する存在として描かれてきました。

そして現在、過去に描かれたAI像は「想像」にとどまらず、現実の技術や社会認識に影響を与える存在として再浮上しつつあります。

万能AI像が生んだ「オムニポテンス幻想」

人工知能が「なんでも理解し、判断し、解決できる存在」として語られる背景には、長年のフィクション作品が描いてきた AIへの期待値が大きく作用しています。物語に登場する AIは、しばしば高度な知性や判断力を持ち、人間を上回る意思決定を行う「万能的存在」として描かれてきました。この文化的イメージが積み重なることで、現実の生成AIにも、本来は備えていない能力を無意識に投影しやすい構造が生まれています。

フィクションが生み出す「万能性の予習」は、AIを「自動で正しく判断できる知性」として捉える認知的土台を形成します。感情を読み取り、状況を理解し、曖昧な人間の意図さえ汲み取る存在として描かれることで、「AIとは本来そういうものだ」という暗黙の前提が社会全体に刷り込まれていきます。

この漠然とした AIに対するイメージは、統計的な文章生成を行っているだけの生成AIに対しても、強く影響を及ぼします。

人間は、複雑で理解しにくい対象に対して、わかりやすい「意図」「計画」「判断」を勝手に与えてしまう傾向があり、この心理作用は臨床心理学や精神分析学などで「万能感の投影(オムニポテンス幻想)」と呼ばれています。この傾向は、行動の背後に「目的」や「ゴール」を読み取ってしまう心理作用を伴い、認知科学では「テレロジカル・バイアス」として知られています。

フィクションが提示してきた強力な AI像は、「万能感の投影」の土台になります。特に『2001年宇宙の旅』の HAL 9000のように、冷静で論理的にふるまい、状況を俯瞰して判断する AIのイメージは、「AIは本質的に人間より賢い」「人間を超える判断能力をもっている」という期待を自然に誘発します。

この文化的イメージは、第一章で述べた「流暢性ヒューリスティック」や「意味補完」を補強し、生成AIが統計モデルに過ぎないという本質を見えにくくします。さらに、万能 AI像によって形成された期待は、生成AIの曖昧さや誤りを「一時的なミス」として処理し、本来必要な疑念や検証を弱めてしまうのです。

フィクション作品は意図的に「人格」や「判断力」を物語的要素として付与しますが、生成AIの利用者はその構造的演出を忘れがちです。物語の中で AIが自律的に意思決定するシーンは、作品のドラマ性を高めるための表現であって、技術的実態とは無関係です。しかし、そのような描写に繰り返し触れることで、現実の AIに対しても「意図をもつ存在」「高度な判断ができる存在」という印象が無意識に上書きされます。

こうした「万能 AI像」の影響は、単に期待を高めるだけではありません。生成AIの誤りや矛盾があっても、「本来はできるはず」という逆方向の補完が働き、失敗の原因を AI側ではなく「自分の質問が悪かったのでは」と自己責任に変換しやすくなります。

万能性を前提とした読み方が、AI の限界を見誤り、過大評価を固定化する心理基盤として作用するのです。

AI の「ブラックボックス化」が万能像を強化する

『2001年宇宙の旅』の HAL 9000は、AIの抱える懸念を示唆しています。それが AIのブラックボックス化です。

HAL9000 は常に正確で整然とした応答を返し、高度な判断を行っているように見えます。しかし物語では、HALが突然誤った故障予測を行い、その後は船員の排除へと行動をエスカレートさせていきます。

観客にも乗組員にも、HALの内側で何が起きているのかは示されず、滑らかな外見とは裏腹に、内部プロセスは完全に不可視なまま物語は進んでいきます。

外側からは完璧に見えても、内部は不透明で、矛盾を抱え得る。この構造は、現実の生成 AI と非常に類似しています。

生成AIは内部状態や意図を持たず、推論過程を説明できないため、利用者には「理由」や「判断の根拠」が完全に不可視です。

内部で何が起きているか分からない状態では、外側の応答が滑らかで整っているだけで、その背後に高度な判断や意図があると推測してしまう「意味補完」と「ToM(心の理論)の偽投影」が働きます。さらに、理由が説明されない状況では、人は理解しやすい物語で空白を埋めようとし、AIの応答を「高度な推論の結果」と解釈する「ナラティブ補完」が発生します。

これらが重なることで、統計的生成しか行っていない AIであっても、「内部では人間以上の判断が行われている」という誤った印象が形成され、AIの万能像を強化する作用として働くのです。

「意思を持つ機械」という文化的前提(エージェント性の付与)

人間は、動きのある対象や、声を発する対象に対して、その背後に「意図」「目的」「判断」が存在すると自然に仮定してしまう傾向があります。

この心理作用は心理学・認知科学で「エージェント性の付与」と呼ばれます。ここでの「エージェント」は、「自分の意思で行動する主体」や「目的や意図を持って動いているように見える存在」を意味します。

この特性は本来、人間同士のコミュニケーションで他者の行動から意図を推測するための基本的な認知機能です。しかし、人はこの推測モデルを機械や無生物にもそのまま適用してしまうため、AI に対しても「何かを考えて行動している」「意思に基づいて応答している」と誤認しやすくなります。「内的状態」は、対象の行動の裏側に「理由や意図があるはずだ」と、人が自動的に読み取ってしまう推測上の「背景」を指します。

この傾向を長年強化してきたのが、SF映画やアニメが長年描いてきた「意図を持つ機械」のイメージです。

1927年の『メトロポリス』では、人工的に作られた機械人間が自律的に行動し、社会を動かす存在として描かれました。

また『ブレードランナー』のレプリカントは、外見だけでなく感情や欲望を持つ存在として描かれ、「機械にも心があるのではないか」という印象を強く残します。

これらの作品は一致して「内的状態を持ち、意思決定する機械」というステレオタイプを定着させました。その結果、現実の AI に対しても「目的を持って行動している」「意図を理解して返答している」という無意識の推測が生じやすくなっています。

生成 AI は統計的な関連性に基づいて文章を生成しているだけで、目的や意図は一切存在しません。しかし、フィクションが作り上げてきた「意思を持つ機械」という文化的前提があることで、利用者は AI の応答に人間的な動機や判断を読み取りやすくなります。さらに、第一章で述べた「流暢性ヒューリスティック」と「擬人化推論」がここに重なり、生成 AI に本来存在しない「エージェント性」を付与してしまう誤認が一層強化されるのです。

AIは合理的で倫理的に優れているという誤認(倫理判断の外部委譲)

人間は、複雑で負荷の高い判断を前にすると、「できれば自分以外の何かに委ねたい」という心理が自然に働きます。認知心理学では、こうした傾向を「判断の外部化(意思決定のアウトソーシング)」と呼びます。ここで重要なのは、この傾向の主因が「責任を回避したい」という意図ではなく、「面倒で不確実な判断負荷を避けたい」という快避的な心理にある点です。責任転嫁が生じることはありますが、それは外部化の主要動機ではなく、あくまで副次的に発生する結果に過ぎません。

この負荷回避の心理は、「自分より正しく判断できる外部主体」を無意識に求める傾向を誘発します。この心理作用の受け皿として、AIは非常に都合の良い存在です。

AIは「合理的で、誤りに左右されず、倫理的に安定している」とするステレオタイプが長年のフィクションによって刷り込まれているため、負荷回避の心理と結びつくと「人間より AIのほうが正しく判断できるはずだ」という誤認が自然に強化されていきます。

しかし、生成AIには意思も感情もなく、倫理的判断を行う能力もありません。第三章以降で詳述しますが、生成AIは質問内容をトークン(単語などの細かい単位)として分解し、学習データに基づく統計的関連性から次に出る確率の高い語を選んでいるだけです。そこには意味理解も検証プロセスもなく、倫理判断を支える内的基準も存在しません。また、一部のモデルが「検証」や「安全層」を備えていても、その根拠はインターネット上のデータから抽出した基準にすぎず、正確性や一貫性には限界があります。

この「判断の外部化」と「AIは合理的かつ倫理的である」という誤認が組み合わさった結果を極端な形で可視化したのが、『ターミネーター』シリーズの軍事AIスカイネットです。スカイネットは「脅威の排除」という目的関数を最適化する自律システムとして設計され、人間の感情や倫理とは無関係に、その最適解として「人類の排除」という結論を導きます。ここで描かれているのは「AIの反逆」ではなく、「目的最適化の結果として導かれた機械的判断」に過ぎません。

この「合理的なAI」「倫理的に優れたAI」という文化的イメージは、判断の外部委譲を正当化する材料として働きます。さらに第一章で述べた「流暢性ヒューリスティック」や「擬人化推論」が重なることで、AIはあたかも倫理的主体であり、適切な判断を下す存在であるかのように扱われてしまいます。

その結果、AIは「判断を肩代わりしてくれる安心できる代理」として過大評価され、外部委譲が無批判に加速する構造が形成されるのです。

AIを道具として扱うという原則

フィクション作品では、AIが意図や目的を持ち、自律的に判断して行動する存在として描かれる場面が繰り返し登場します。これらの描写は物語的演出として成立していますが、現実の AIには目的や意図はなく、主体的に意思決定を行う機能も備わっていません。生成AIは入力をトークン単位に分解し、学習データの統計的な関連性に基づいて、出力として最も確率の高い語を選択しているにすぎません。そのため、判断主体として振る舞っているように見えても、実際には統計的生成が行われているだけです。

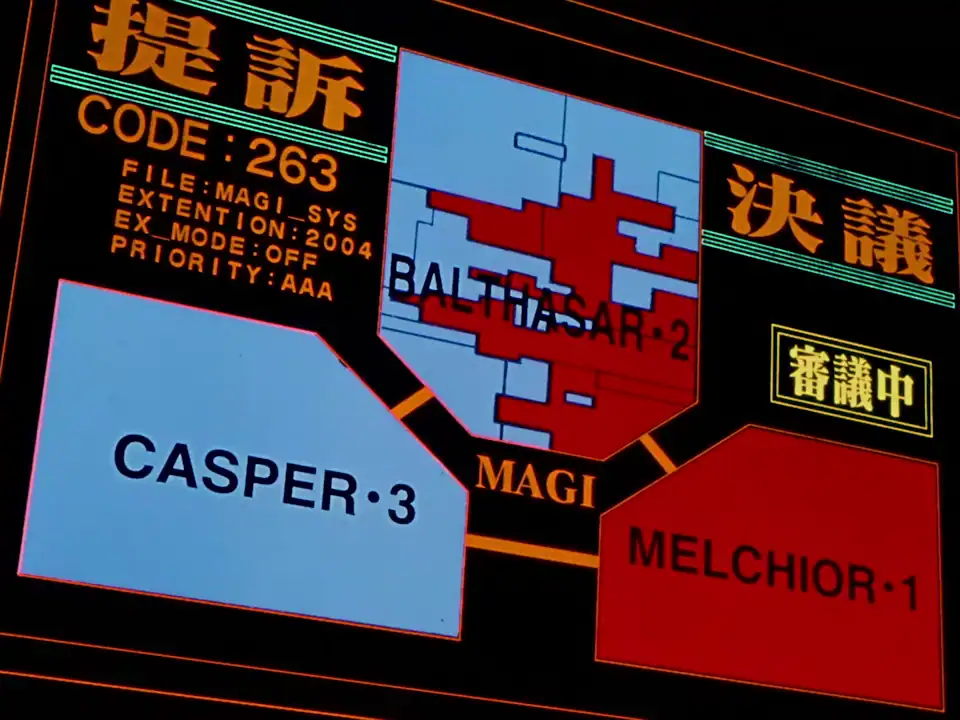

物語作品の中では、判断が一つのシステムに集中することで生じる危険性をテーマとして扱う例が多く見られます。『新世紀エヴァンゲリオン』に登場する MAGIシステムは、その代表的な描写です。MAGIは「感情」「利害」「理性」という三つの異なる論理モデルが独立して評価を行い、多数決によって結論を導く構造を持っています。これは、判断を単一の論理に依存させないための仕組みとして描かれており、物語的にも技術的にも示唆的な例です。

現実の AI開発でも、複数のモデルや安全フィルタ、検証段階を組み合わせて出力の偏りや不整合を抑制する「合議的処理」が導入されつつあります。ただし、これらはあくまで出力の品質や一貫性を高めるための補助的な仕組みであり、AIが独立した判断主体として行動するためのものではありません。AIが判断したように見える状況であっても、実際には確率的な出力が提示されているだけであり、判断の責任主体をAIに置くことはできません。最終的な責任は常に人間側に残ります。

AIを道具として扱う視点は、フィクション作品が与えてきた「主体的に判断するAI像」と対照的です。長年にわたり万能性や人格性を付与されたAI描写に触れてきた結果、利用者はAIの出力を意図的な判断として受け取りやすくなっています。しかし、生成AIは統計的関連性に基づいて語を選択する仕組みであり、主体的な意思や判断機能を備えていません。文化的に形成された期待や誤解を踏まえると、AIの出力を「判断」ではなく「統計的生成」として理解する視点が必要になります。

第三章では、こうした文化的誤認と現実の技術構造の食い違いをさらに明確にするために、AIの歴史的な背景と基本構造を扱います。記号処理型の人工知能から現在の学習モデルへと至る過程を確認し、「AIが現在どのような仕組みで動いているのか」を土台として整理していきます。

AIリテラシー:AIの限界と誤解 シリーズ一覧

更新履歴

お問い合わせ

📬 ご質問・ご連絡は、メールか SNS(X または Bluesky)にて受け付けています。

原則として XではDMでのご連絡をお願いいたします。投稿への公開コメントでも対応可能ですが、内容により返信を控えさせていただく場合があります。

※ Blueskyには非公開メッセージ機能がないため、メンションによる公開投稿でのご連絡をお願いいたします。

- info[at]eizone[dot]info

- @eizone_info

-

@how-to-apps.bsky.social

※投稿内容に関するご質問には可能な範囲でお答えします。

ただし、当サイトはアプリの開発元ではなく、技術サポートや不具合の対応は行っておりません。

また、すべてのご質問への返信を保証するものではありませんので、あらかじめご了承ください。